Chi ha inventato il cestino del computer?

Il cestino del computer è una delle funzionalità più comuni e familiari nei sistemi operativi moderni. Permette agli utenti di eliminare facilmente file e cartelle, ma mantiene una copia di questi dati per un certo periodo, in modo che possano essere recuperati nel caso in cui vengano eliminati per errore. Nonostante sembri una funzione scontata, la sua invenzione ha avuto una genesi interessante.

L'origine del cestino

La storia del cestino del computer risale agli anni '80, durante la diffusione dei sistemi operativi grafici. Uno dei primi esempi di questa funzione si trova nel sistema operativo Macintosh di Apple. Il concept e la sua realizzazione sono generalmente attribuiti a Susan Kare, una grafica e designer di interfacce utente che ha lavorato con Steve Jobs. Kare è conosciuta per aver creato molte delle icone originali per il Mac, tra cui quella che simboleggia il cestino.

Nel 1984, con il lancio del Macintosh, Apple presentò una nuova interfaccia utente grafica (GUI), che era una novità rispetto ai sistemi operativi precedenti, basati principalmente su linee di comando. L'idea del cestino nacque per semplificare la gestione dei file eliminati. L'utente poteva “buttare” i file nel cestino, ma, se desiderava, li avrebbe potuti recuperare in seguito, evitando la perdita permanente dei dati per errore.

Come funzionava

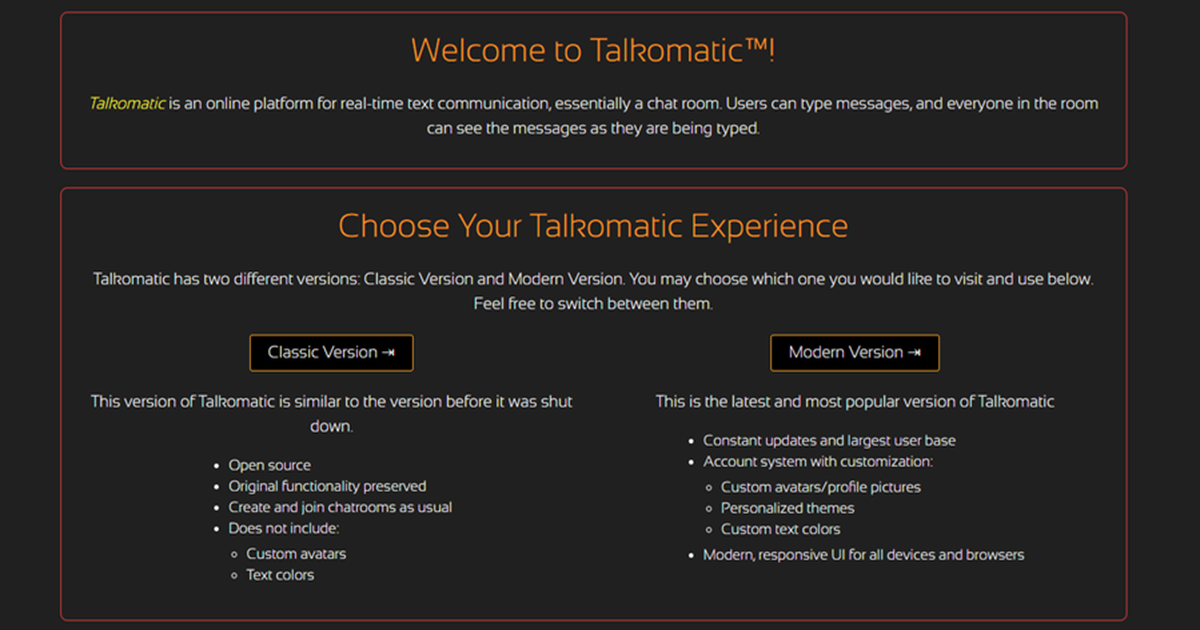

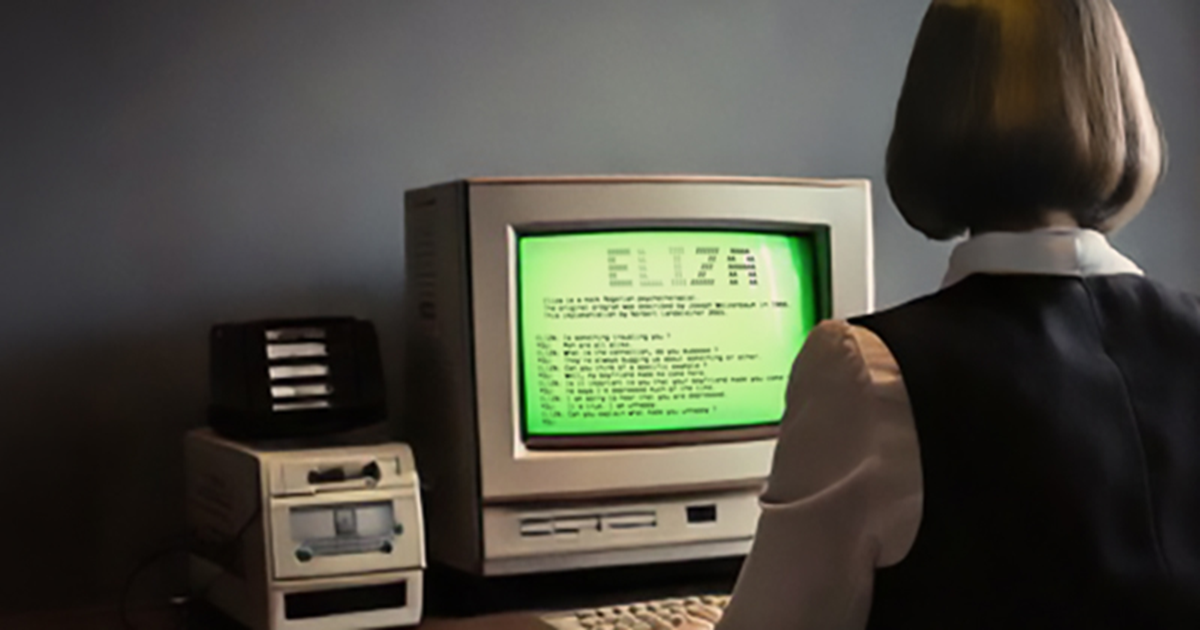

Nel sistema Macintosh, il cestino era un’icona situata nel Dock, una barra di avvio rapido, che gli utenti utilizzavano per spostare i file che volevano eliminare. Quando il cestino veniva svuotato, i file venivano definitivamente rimossi dal sistema, ma, prima di questo, era possibile recuperarli facilmente. Il concetto di un'area di “recupero” diventò molto popolare, tanto che fu integrato anche nel sistema Windows di Microsoft, con l'introduzione di Windows 95.

Nel caso di Windows, il cestino aveva un comportamento simile a quello del Macintosh, ma con alcune modifiche e miglioramenti. Ad esempio, l'icona del cestino di Windows era progettata per mostrare un'illustrazione di un secchio della spazzatura, che si riempiva man mano che i file venivano eliminati. Inoltre, Windows ha introdotto la possibilità di configurare il cestino, come determinare la dimensione massima e scegliere se eliminare i file direttamente o spostarli nel cestino.

La funzione del cestino oggi

Oggi il cestino è una funzione standard in praticamente tutti i sistemi operativi, sia desktop che mobili. In macOS, ad esempio, il cestino è rappresentato da un'icona di un secchio che si svuota quando i file vengono eliminati. Su Windows, il cestino è sempre presente nel desktop e può essere personalizzato per adattarsi alle preferenze dell'utente.

Nel corso degli anni, molte modifiche sono state apportate per migliorare l'affidabilità e la funzionalità del cestino, come la possibilità di visualizzare i file eliminati, ripristinarli, o anche di configurare lo svuotamento automatico del cestino a intervalli prestabiliti.

Il cestino del computer è un'invenzione che ha rivoluzionato il modo in cui gli utenti interagiscono con i file e le cartelle su un computer, permettendo di recuperare facilmente i dati eliminati per errore. Sebbene Susan Kare sia la figura principale nell'ideazione di questa funzione su Macintosh, è stata l’adozione di questa funzionalità da parte di altri sistemi operativi come Windows a rendere il cestino una caratteristica universale, che oggi utilizziamo senza pensarci troppo.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.