Dennis Ritchie: il padre del linguaggio C e del sistema Unix

Dennis MacAlistair Ritchie (1941 – 2011) è stato uno degli ingegneri e scienziati informatici più influenti della storia. Sebbene il suo nome non sia noto al grande pubblico quanto quello di figure come Steve Jobs o Bill Gates, il suo contributo è stato fondamentale per lo sviluppo dell’informatica moderna. Senza il suo lavoro, gran parte delle tecnologie su cui si basano i computer, gli smartphone e persino Internet non esisterebbero nella forma che conosciamo oggi.

Gli inizi e la formazione

Nato a Bronxville, New York, Ritchie studiò fisica e matematica applicata all’Università di Harvard, dove sviluppò un forte interesse per i calcolatori. Negli anni Sessanta entrò nei Bell Labs, uno dei centri di ricerca più innovativi del Novecento, che fu la culla di invenzioni decisive come il transistor e il linguaggio C.

La nascita del linguaggio C

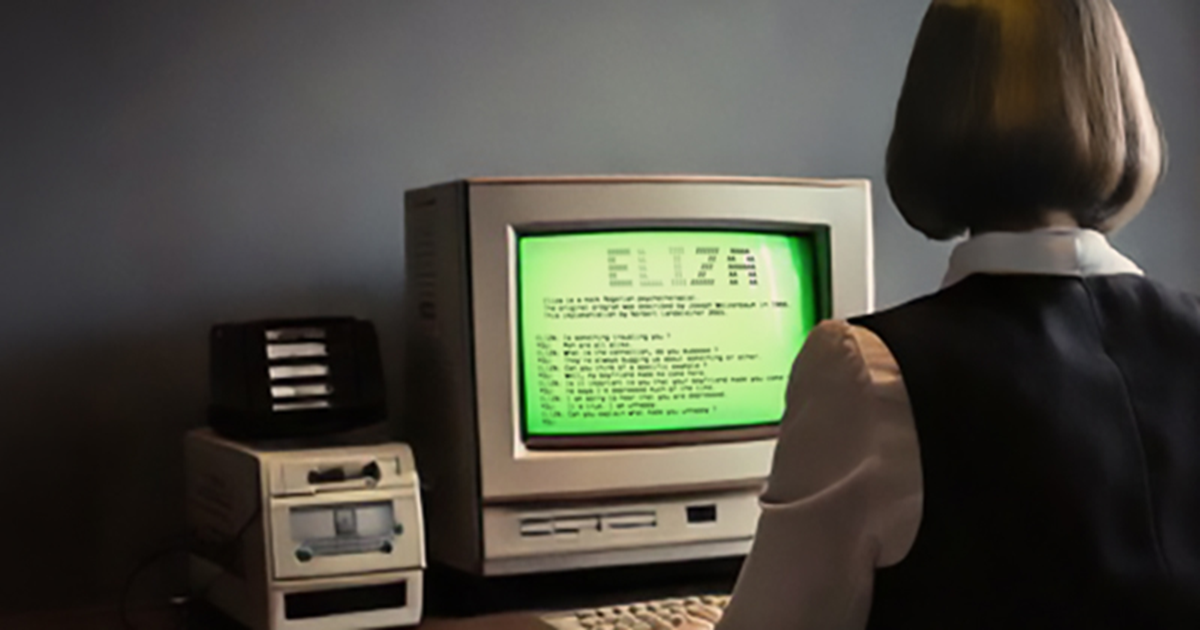

Il contributo più noto di Ritchie fu la creazione del linguaggio di programmazione C all’inizio degli anni Settanta. Sviluppato come evoluzione del linguaggio B (a sua volta derivato dal BCPL), C si distinse per la sua efficienza e portabilità. Permetteva di scrivere programmi di basso livello, vicini al linguaggio macchina, mantenendo però un alto grado di astrazione e leggibilità. C divenne rapidamente lo standard per la programmazione di sistemi operativi e applicazioni, influenzando in seguito linguaggi come C++, Java, C#, e persino Python e Go.

Il sistema operativo Unix

Parallelamente alla creazione di C, Ritchie lavorò insieme a Ken Thompson alla realizzazione di Unix, un sistema operativo rivoluzionario. Unix si distingueva per semplicità, modularità e capacità di essere eseguito su diverse macchine, caratteristiche che lo resero la base di molti sistemi operativi moderni. Dalle sue idee nacquero varianti e discendenti diretti: BSD, Linux, macOS, Android e iOS devono molto a Unix. Oggi, l’eredità di questo sistema operativo è ovunque, dai server web agli smartphone.

Riconoscimenti

Per il suo contributo, Dennis Ritchie ricevette nel 1983 il Premio Turing, considerato il “Nobel dell’informatica”, insieme a Ken Thompson. Nel 1999 fu insignito della National Medal of Technology dagli Stati Uniti. Tuttavia, non cercò mai i riflettori, preferendo lavorare dietro le quinte.

L’eredità

Dennis Ritchie morì nel 2011, pochi giorni dopo Steve Jobs, ma la sua scomparsa passò in gran parte inosservata al di fuori della comunità informatica. Eppure, il suo impatto è incalcolabile: ogni volta che utilizziamo un computer, un telefono o navighiamo online, stiamo beneficiando indirettamente delle sue invenzioni.

Il linguaggio C e Unix rappresentano ancora oggi colonne portanti della programmazione e dei sistemi operativi, dimostrando la visione lungimirante di Ritchie.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.