Ronald Wayne: il socio dimenticato della Apple

Ronald Wayne è uno dei nomi meno noti nella storia della tecnologia, ma il suo breve coinvolgimento nella fondazione di Apple Inc. lo rende una figura affascinante e, per certi versi, tragica. Nato il 17 maggio 1934 a Cleveland, Ohio, Wayne è un ingegnere e inventore statunitense che ha avuto un ruolo cruciale nei primi giorni di vita della Apple, affiancando Steve Jobs e Steve Wozniak nella creazione di quella che sarebbe diventata una delle aziende più influenti del mondo.

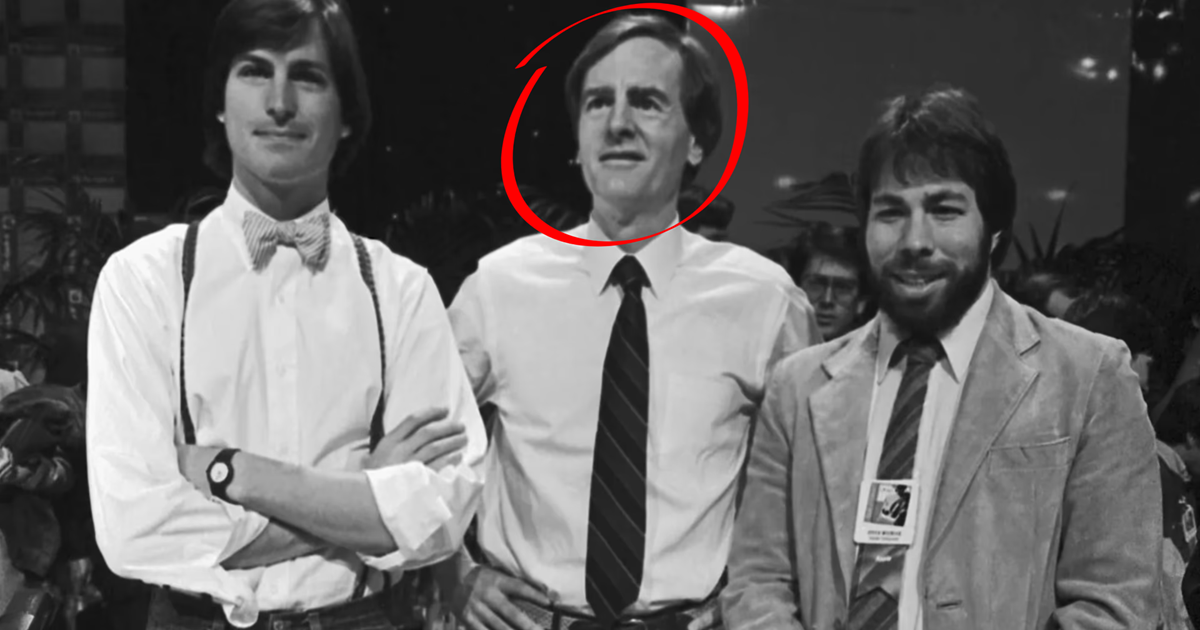

Il terzo fondatore

Nel 1976, Steve Jobs e Steve Wozniak, due giovani appassionati di tecnologia, stavano cercando di trasformare il loro hobby in un’impresa. Jobs, allora ventunenne, decise di coinvolgere Ronald Wayne, di vent'anni più anziano, come figura di supporto e guida. Wayne, che all’epoca lavorava presso Atari insieme a Jobs, aveva esperienza nella gestione e nella redazione di documenti legali. Fu lui a scrivere il primo contratto sociale della Apple e a disegnare il primo logo dell’azienda: un'immagine elaborata di Isaac Newton seduto sotto un albero di mele.

L’uscita dalla Apple

Ronald Wayne deteneva il 10% delle azioni della neonata Apple. Tuttavia, appena undici giorni dopo la firma del contratto, decise di vendere la sua quota per soli 800 dollari. Il motivo principale fu la paura: Wayne aveva già avuto esperienze imprenditoriali fallimentari e temeva di essere ritenuto finanziariamente responsabile in caso di debiti o insuccessi dell’azienda. A differenza di Jobs e Wozniak, Wayne aveva beni personali che potevano essere messi a rischio. Successivamente ricevette altri 1.500 dollari per rinunciare formalmente a qualsiasi diritto futuro sull’azienda.

Se avesse mantenuto la sua quota del 10%, oggi varrebbe decine di miliardi di dollari.

Dopo Apple

Dopo l'uscita da Apple, Ronald Wayne proseguì la sua carriera in ambito ingegneristico, lavorando in diverse aziende e, in seguito, gestendo un piccolo negozio di francobolli e monete rare nel Nevada. Col tempo, la sua storia è diventata quasi una leggenda, simbolo di opportunità mancate e decisioni prudenti che si rivelano enormi sliding doors.

Nonostante tutto, Wayne ha sempre dichiarato di non pentirsi della sua decisione. Ha ammesso che non avrebbe retto lo stress e la pressione che sarebbero arrivati con il successo dell’azienda. “La decisione era giusta per me, in quel momento della mia vita”, ha affermato in varie interviste.

Un personaggio fuori dagli schemi

Ronald Wayne è spesso visto come il “terzo uomo” dimenticato, ma la sua figura ha acquisito una certa notorietà col passare degli anni. Ha scritto un’autobiografia e partecipato a diversi eventi e documentari in cui racconta la sua versione dei fatti, con uno stile pacato e riflessivo, lontano dalla mitizzazione di Jobs e dalla genialità creativa di Wozniak.

La sua storia ci ricorda che dietro ogni grande successo ci sono anche decisioni difficili, timori personali e scelte che, con il senno di poi, sembrano incredibili. Ronald Wayne non è diventato miliardario, ma il suo ruolo, seppur breve, nella nascita di Apple lo rende parte integrante della storia della tecnologia moderna.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.