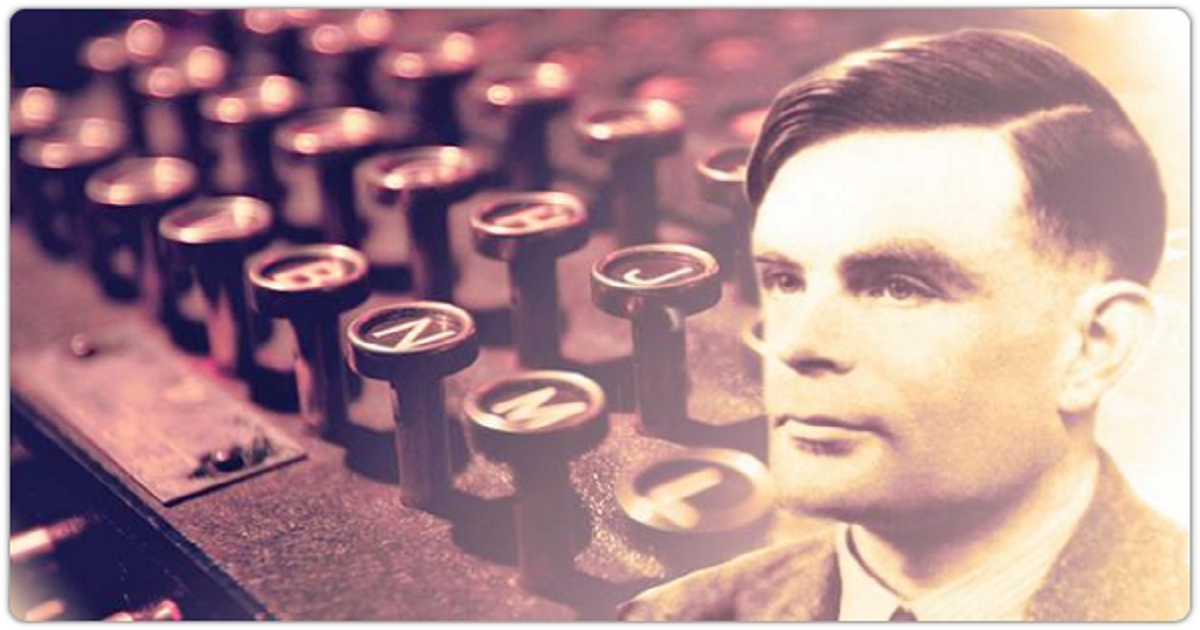

Alan Turing e le teorie di “on computable numbers”

Alan Turing è una figura fondamentale nella storia della scienza e della tecnologia, noto per il suo contributo rivoluzionario nell’ambito della matematica, della logica e dell’informatica. Una delle sue opere più influenti è senza dubbio il saggio del 1936, “On Computable Numbers, with an Application to the Entscheidungsproblem”. Questo lavoro gettò le basi teoriche per la nascita dell’informatica moderna, introducendo concetti che avrebbero trasformato il modo in cui l’umanità concepisce il calcolo e l’automazione.

Il saggio fu scritto in risposta al cosiddetto Entscheidungsproblem, o "problema della decisione", un quesito posto dal matematico David Hilbert. L’obiettivo era determinare se fosse possibile sviluppare un metodo meccanico in grado di risolvere ogni problema matematico esprimibile in linguaggio formale. Turing affrontò questa questione definendo un modello astratto di calcolo, oggi noto come "macchina di Turing".

La macchina di Turing è un dispositivo teorico costituito da un nastro infinito suddiviso in celle, ciascuna delle quali può contenere un simbolo. Un “testa” di lettura/scrittura si muove lungo il nastro, leggendo e modificando i simboli secondo un insieme di regole predefinite. Questo modello estremamente semplice si è rivelato capace di rappresentare qualsiasi processo computazionale che può essere eseguito meccanicamente. La sua potenza risiede nella generalità: ogni problema risolvibile algoritmicamente può essere simulato da una macchina di Turing.

Turing dimostrò che non tutti i numeri sono "computabili", cioè non esiste un algoritmo che possa generare ogni numero reale. Per esempio, alcuni problemi matematici non hanno soluzione computabile, come il famoso problema dell’arresto. Questo problema riguarda la possibilità di determinare, dato un programma e un input, se il programma terminerà o continuerà a funzionare indefinitamente. Turing dimostrò che non esiste un metodo generale per risolverlo, un risultato che ha implicazioni profonde per la teoria della computazione.

Il lavoro di Turing non si limitò al mondo astratto della teoria. Durante la Seconda Guerra Mondiale, il suo genio trovò applicazioni pratiche nella crittoanalisi. A Bletchley Park, guidò il team che sviluppò il dispositivo Bombe, usato per decifrare i messaggi cifrati dalla macchina Enigma dei tedeschi. Questo contributo accelerò significativamente la fine del conflitto.

Le implicazioni del saggio "On Computable Numbers" vanno ben oltre la matematica. Ha aperto la strada alla creazione dei primi computer elettronici e ha influenzato campi come l’intelligenza artificiale, la teoria dell’informazione e la filosofia della mente. Turing stesso anticipò alcune delle domande fondamentali dell’intelligenza artificiale nel suo famoso articolo del 1950, in cui propose quello che oggi chiamiamo "Test di Turing" per valutare la capacità di una macchina di mostrare comportamenti intelligenti.

La genialità di Turing ha lasciato un’eredità immensa, ma la sua vita personale fu tragicamente segnata dalle persecuzioni dovute alla sua omosessualità, allora considerata un reato nel Regno Unito. La sua morte prematura nel 1954 privò il mondo di una delle menti più brillanti del XX secolo. Tuttavia, il suo lavoro continua a ispirare e a plasmare il futuro, rendendolo una delle figure più celebrate nella storia della scienza e della tecnologia.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.