Open Source: significato e storia

Quando si definisce un software "libero", si intende che rispetta le libertà essenziali degli utenti: la libertà di eseguire il programma, di studiare il programma e di ridistribuire delle copie con o senza modifiche.

Originariamente, il termine open source si riferiva al software open source (OSS, Open Source Software).

Il software open source è un codice progettato per essere accessibile pubblicamente. Chiunque può vederlo, modificarlo e distribuirlo secondo le proprie necessità.

Viene sviluppato tramite un approccio decentralizzato e collaborativo, che si basa sulla "peer review", ovvero le revisioni condotte dai colleghi e professionisti IT, e sul lavoro della community. Poiché sviluppato dalle community e non da una singola azienda o individuo, il software open source risulta essere una soluzione più economica, flessibile e longeva rispetto ai software proprietari.

Parlare di Linux, Android, Apache, sono solo alcuni dei nomi che usiamo nel quotidiano, divenuti di gergo comune, ma che dietro alle loro community di sviluppatori che li hanno realizzati, c’è un'intensa e convulsa storia che è interessante conoscere, soprattutto se si lavora nel comparto IT dove il concetto di open source sta rivoluzionando il mercato del software.

La storia dell’open source, poggia le sue basi molto lontano, quando agli albori dell’informatica, programmatori e sviluppatori condividevano il software per imparare gli uni dagli altri e per far evolvere il campo dell’informatica.

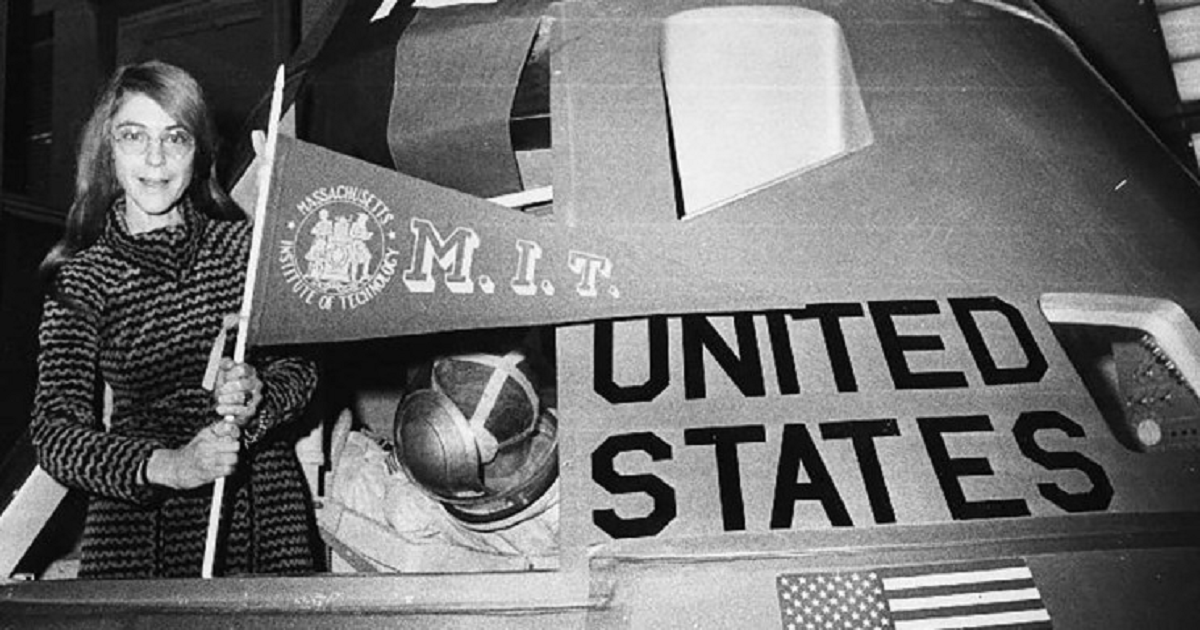

Si è parlato molto del Tech Model Railroad Club dell’MIT, della comunità hacker, ma anche dei dipartimenti di intelligenza artificiale del MIT e della Stanford University. Gli accademici, da sempre hanno collaborato per un fine comune ovvero accrescere le proprie competenze e quindi le competenze di tutti, per migliorare l’intero sistema, pensando che il contributo di ogni singolo possa portare ad un enorme vantaggio al risultato finale per tutta la comunità.

Infatti, dagli anni ’50 fino all’inizio degli anni ’70, era normale per gli utenti di computer disporre di software libero, quindi aperto, condiviso tra le persone che usavano i computer i quali in quel periodo storico erano prodotti di nicchia, appannaggio delle università e delle grandi organizzazioni.

I costi del software aumentano

All’epoca il business era la vendita dell’hardware e quindi i produttori di computer apprezzavano il fatto che le persone creavano e distribuivano il software che a sua volta rendeva il loro hardware utile ad un determinato scopo.

Ma all’inizio degli anni ’70, la complessità del software e i costi ad esso collegati aumentarono drasticamente, e l’industria del software in forte crescita era in competizione con i prodotti software in bundle realizzati dai fornitori di hardware, che risultavano gratuiti in quanto il loro costo era incluso nel costo dell’hardware.

Nel 1969, il governo degli Stati Uniti d’America disse che il software in bundle risultava anti concorrenziale, e da lì in avanti tutto cambiò e il software a pagamento iniziò la sua escalation fino ad arrivare all’estensione al software della legge sul copyright nel 1980.

Le Free Software Foundation

Richard Stallman, membro della comunità hacker e del laboratorio di intelligenza artificiale del MIT, nonché autore di molti software, nel 1983 intravedendo profeticamente che l’informatica sarebbe divenuta in un prossimo futuro un controllo delle persone, pensò e formulò il concetto di diritti e libertà digitali degli utenti e così decise di avviare un progetto di scrittura di un sistema operativo NON proprietario dal nome GNU (acronimo ricorsivo di "GNU's Not Unix", un sistema operativo Unix-like, ideato nel 1984 da Richard Stallman e promosso dalla Free Software Foundation), in quanto non voleva accettare accordi di NON divulgazione avrebbero comportato la mancata condivisione del codice sorgente, legge non scritta, ma alla base della cultura hacker, nata per altro al MIT.

Quindi un anno dopo, ad ottobre del 1984, prese vita la “Free software Foundation” e la logica del copyleft, ovvero l’esatto opposto del copyright, e quindi l’incentivazione alla divulgazione e la condivisione del codice sorgente tramite la famosa GPL (GNU Public License) una licenza che fornisse garanzie a tutela degli utenti, scritta secondo leggi internazionali.

Il concetto era semplice e nello stesso tempo rivoluzionario. Dove va il codice sorgente Free, va anche la libertà di copiarlo, modificarlo, condividerlo senza poterlo mai chiudere in software proprietario.

Tenete sempre in considerazione questo importante tassello nella storia dell’informatica, lo ritroveremo ogni volta che si parlerà della logica della disclosure pubblica, delle attività di bug hunting e quindi nella divulgazione e nella trasparenza sulle vulnerabilità rilevate nei prodotti software.

Il kernel di GNU e il progetto Linux

Intanto uno studente, Linus Torvalds, mentre frequentava l’università di Helsinki, stanco dei limiti della licenza del sistema operativo MINIX, che ne limitava il suo utilizzo solo in ambito didattico, iniziò a scrivere un proprio kernel (nucleo o cuore di un sistema operativo) con l’aiuto di altri hacker disseminati in giro per il pianeta.

All’inizio era solo un emulatore di terminale che poi piano piano, utilizzando software liberi del progetto GNU, come il compilatore GCC, le librerie, la bash, studiando le specifiche POSIX (termine tra l’altro coniato da Richard Stallman per definire gli standard per un sistema operativo) riuscì a produrre la prima versione del kernel Linux 0.0.1, senza interfaccia grafica, che fu pubblicata su Internet il 17 settembre 1991 e la seconda nell’ottobre dello stesso anno.

Nel 1991, avvenne una vera e propria “scossa tellurica” nel mondo dell’informatica, inizialmente piccola, ma che poco a poco si rivelò vincente verso i big della Silicon Valley, in quanto dalla combinazione del kernel Linux e del progetto GNU, venne rilasciato il sistema operativo GNU/Linux distribuito sotto licenza GPL.

La cattedrale e il bazaar

Eric Steven Raymond, evangelista della Free Software Foundation, nel 1997 pubblico il libro “La cattedrale e il bazaar”, che illustrava le differenze tra free software e software commerciale.

Mentre per la Cattedrale ogni pezzo, prima di essere costruito deve essere validato da una commissione con evidenti rallentamenti ed inefficienze, al contrario il Baazar, è l’emporio della mentalità hacker e quindi delle nuove idee, dove ogni programmatore poteva contribuire a suo modo, utilizzando il software liberamente e gratuitamente.

Netscape Communicator diventa free software

Tutto iniziava ad evolversi rapidamente, infatti nel 1998, grazie a questo libro la Netscape Communications Corporation rilasciò la popolare suite Internet Mozilla (allora Netscape Communicator) come free software lasciando tutti a bocca aperta. Richard Stallman pensò e codificò nella GPL.

Un nuovo nome

Ma il termine “free software” per la sua intrinseca ambiguità (in inglese free vuol dire sia libero che gratuito), venne visto come scoraggiante dal punto di vista commerciale, oltre che un generatore di confusione, ecco che all’interno del movimento free software, venne proposto un nuovo termine, ovvero “open source”, ideato dalla meteorologa Christine Peterson nel 1998, assieme a Bruce Perens, Eric S. Raymond, Ockman che parlarono di Open Source per la prima volta già nel 1997.

Venne quindi effettuata una ridefinizione ideologica del software libero, evidenziandone anche i vantaggi pratici per le aziende che piacque molto e venne adottato da giganti del calibro di Netscape, IBM, Sun Microsystems e HP.

L’etichetta “open source” venne ufficialmente creata durante una sessione strategica tenutasi il 3 febbraio 1998 a Palo Alto, in California, subito dopo l’annuncio del rilascio del codice sorgente di Netscape. Oggi esiste la Open Source Initiative, partita proprio da quella conferenza nel 1998.

Differenze tra Free Software, Open Source e Software Chiuso

Quindi, sebbene Open source e free software siano modelli simili, c’è una sostanziale differenza. Definire genericamente un software come Open Source, significa che puoi guardare il suo codice sorgente, ma non necessariamente vengono garantite la libertà digitale della Free Software Foudation, perché esistono licenze come ad esempio la BSD che ti permette di prendere tale codice e chiuderlo in un software proprietario.

Per Free Software invece si intende software libero, quindi filosoficamente più puro, utilizzabile senza limitazioni nella libertà, ma esso non potrà mai diventare proprietario pena cause legali, penali ed economiche.

Il software chiuso o software proprietario o "a sorgente chiuso". Quest'ultimo, essendo altamente protetto, è accessibile solo dai proprietari del codice sorgente, che dispongono dei diritti legali esclusivi. Il codice sorgente chiuso, a livello legale, non è modificabile o riproducibile e l'utente paga per utilizzare il software "così com'è", senza poterlo alterare per nuovi utilizzi o condividerlo con le community.

Da li in poi la storia del movimento open source con le sue numerose licenze Apache, BSD, Mozilla, GPL, la conosciamo bene, tra convention, hacking, distribuzioni linux e software di ogni tipo, quello che ci ha insegnato tutto questo è che molte delle cose migliori che ha fatto l’uomo, sono state fatte attraverso la collaborazione e la trasparenza e la presenza di una solida comunità a contorno e che la logica del modello chiuso, in generale, prima o poi arriverà ad un declino.

Un dirigente di Microsoft disse pubblicamente nel 2001: "l’open source è un distruttore della proprietà intellettuale". Probabilmente in quel periodo poteva sembrare corretto pensarla in questo modo, ma oggi, risulta ancora applicabile?

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.